註:本文同步更新在Notion!(數學公式會比較好閱讀)

深層前饋式神經網路(Deep Feedforward Neural Networks, DFNN)是前饋式神經網路的一種擴展。與多層感知機(MLP)相似,DFNN 由多層神經元組成,但特點在於隱藏層的數量較多,通常有多層隱藏層,因此被稱為「深層」網路。這樣的深度讓它能夠處理更加複雜的模式和數據結構。

DFNN 的目的是通過多層隱藏層的神經元來提取更高層次的數據特徵。這些特徵的提取過程從底層開始,逐層提取出更加抽象的數據信息,從而能夠學習和表示更複雜的模式。

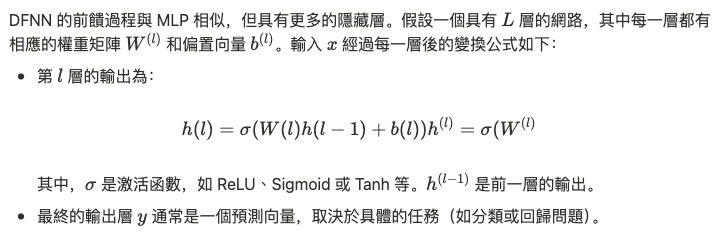

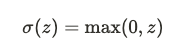

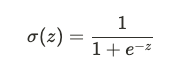

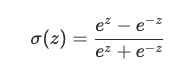

在每層的神經元中,激活函數 $\sigma$ 是一個關鍵組件,它能夠引入非線性,使網路能夠學習複雜的非線性映射。常見的激活函數有:

多層隱藏層允許 DFNN 提取更加抽象的特徵。每一層的神經元在進行線性變換和非線性激活後,可以捕捉到數據中不同層次的模式。隨著層數的增加,網路能夠更好地描述數據中的複雜關係。

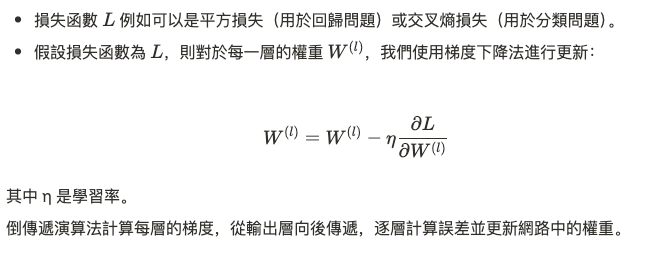

DFNN 的訓練過程主要依賴於倒傳遞演算法(Backpropagation),該演算法通過計算每一層的梯度來更新權重和偏置。其目標是最小化損失函數,通常使用梯度下降法來調整網路的參數。

當網路層數增加時,傳統的激活函數(如 Sigmoid 和 Tanh)容易出現梯度消失問題,這使得網路在訓練過程中無法有效更新權重。為了解決這個問題,深層網路中通常使用 ReLU 激活函數,這種函數在輸入大於零的區域內能夠保持非零梯度,從而能夠緩解梯度消失問題。